728x90

반응형

인코더–디코더와 트랜스포머 아키텍처: AI 언어 모델의 핵심 구조

✨ AI가 문장을 '이해하고' '말하는' 방식은?

사람처럼 말하고 글을 쓰는 AI, 예를 들어 ChatGPT나 번역기(Papago, DeepL)가 어떻게 말을 배울 수 있을까요? 그 비밀은 바로 인코더–디코더(Encoder–Decoder) 구조와 그 구조를 똑똑하게 만든 트랜스포머(Transformer) 아키텍처에 있습니다.

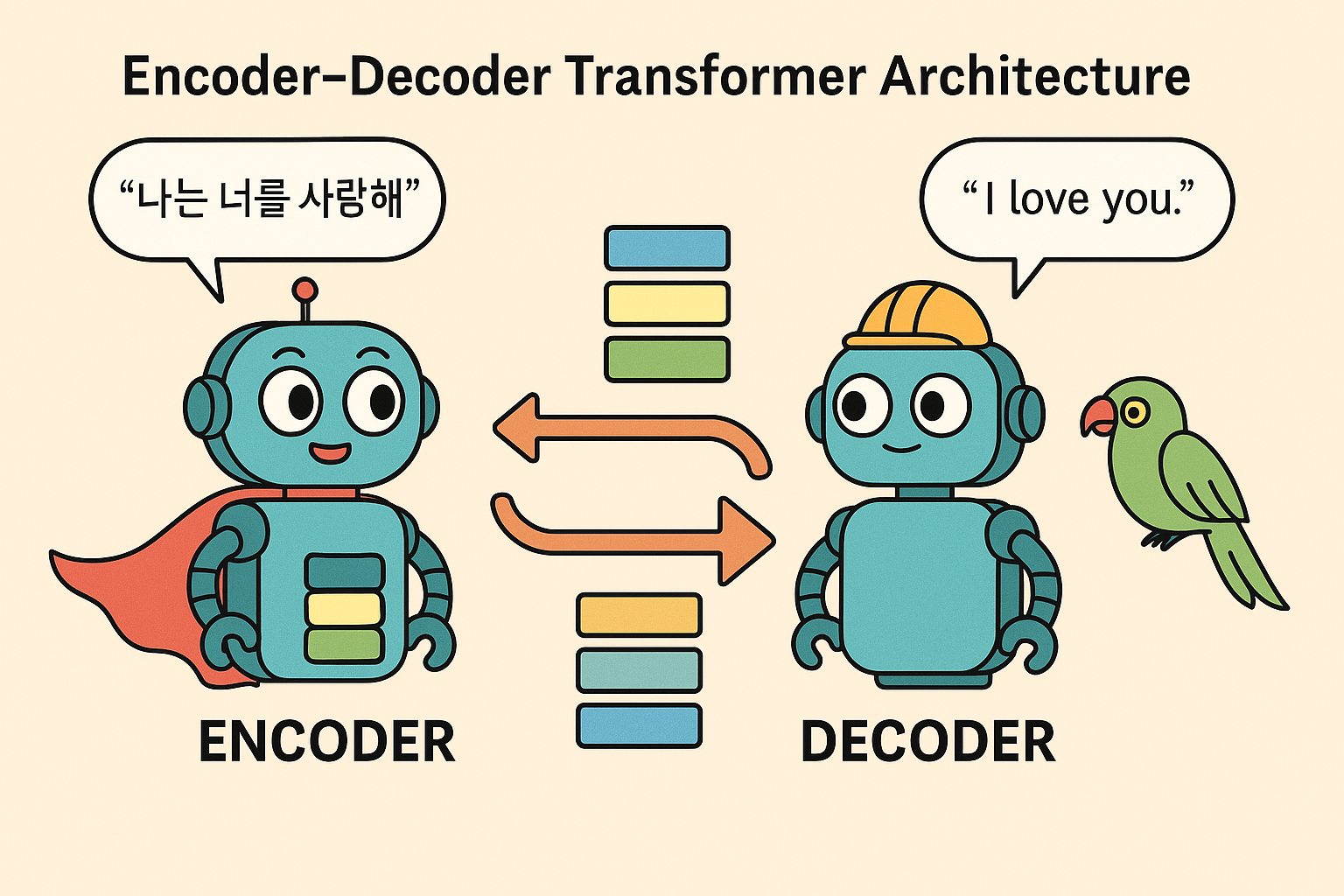

📌 인코더–디코더 구조란?

AI가 문장을 처리할 때 입력과 출력을 나누어 처리하는 기본적인 구조입니다.

| 구성 | 역할 |

|---|---|

| 인코더 (Encoder) | 입력 문장을 벡터로 바꿔서 의미를 압축 |

| 디코더 (Decoder) | 그 벡터를 바탕으로 출력 문장을 생성 |

📖 예시

입력: “나는 너를 사랑해” → 인코더: 의미 벡터로 요약 → 디코더: “I love you”

🔁 트랜스포머(Transformer)란?

트랜스포머는 인코더–디코더 구조를 더 강력하고 효율적으로 만든 딥러닝 기반 아키텍처입니다. 2017년 구글의 논문 “Attention is All You Need”에서 제안되었고, 현재 GPT, BERT, T5 등 주요 AI 모델의 기반입니다.

💡 핵심 구성 요소

- Self-Attention: 문장 내 단어들 사이의 관계를 파악

- Multi-Head Attention: 여러 시선으로 단어 의미 분석

- 포지셔널 인코딩: 단어의 순서 정보를 추가로 부여

🧱 트랜스포머 전체 구조 흐름

- 인코더 블록: 입력 문장 → 의미 벡터로 압축

- 디코더 블록: 인코더 출력 + 이전 단어 → 다음 단어 생성

- 반복적으로 문장을 생성하여 자연스러운 출력 완성

📊 기존 방식과 트랜스포머 비교

| 항목 | 기존 RNN/LSTM | 트랜스포머 |

|---|---|---|

| 처리 방식 | 단어 순서대로 처리 | 전체 문장을 동시에 처리 |

| 속도 | 느림 | 빠름 (병렬 처리 가능) |

| 문맥 이해력 | 짧은 문장에 강함 | 긴 문장에도 강력함 |

| 대표 모델 | Seq2Seq, LSTM | GPT, BERT, T5 |

🎯 트랜스포머의 활용 분야

- 🧠 ChatGPT, Claude 같은 챗봇

- 🌍 Google Translate, DeepL 등의 번역기

- 📝 자동 요약, 블로그 글쓰기

- 🧪 Copilot 같은 코드 생성기

- 🎬 이미지/음성 생성의 기반 구조

✅ 결론

인코더–디코더 구조는 AI가 언어를 이해하고 생성하는 기본 구조이고, 트랜스포머는 이 과정을 더 빠르고 정교하게 만든 AI 언어 모델의 핵심 기술입니다.

📌 한 줄 요약

트랜스포머는 문장을 한 번에 통째로 이해하는 AI 기술이며, 인코더–디코더는 그 기반이 되는 구조입니다.

🔖 추천 해시태그

#트랜스포머 #인코더디코더 #SelfAttention #GPT구조 #AI언어모델 #딥러닝기초 #NLP구조 #TransformerArchitecture #자연어처리 #AI글쓰기원리 #AI번역기술 #ChatGPT원리 #인공지능작동원리 #트랜스포머설명 #포지셔널인코딩 #멀티헤드어텐션 #생성형AI핵심기술

반응형

'경제경영비즈니스' 카테고리의 다른 글

| 에어비앤비와 외부 플랫폼 달력 동기화로 오버부킹 방지하는 방법 (5) | 2025.05.25 |

|---|---|

| VAN(Value Attention Network)란? 인공지능의 주의력을 높이는 핵심 기술 (0) | 2025.05.25 |

| 프롬프트 엔지니어링(Prompt Engineering)이란? (0) | 2025.05.25 |

| LLM과 자연어처리: AI가 사람처럼 말할 수 있는 이유 (1) | 2025.05.24 |

| 제이슨 자다(Jason Zada): 데이터 시대의 창작자, AI 시대의 경고자 (0) | 2025.05.24 |