728x90

반응형

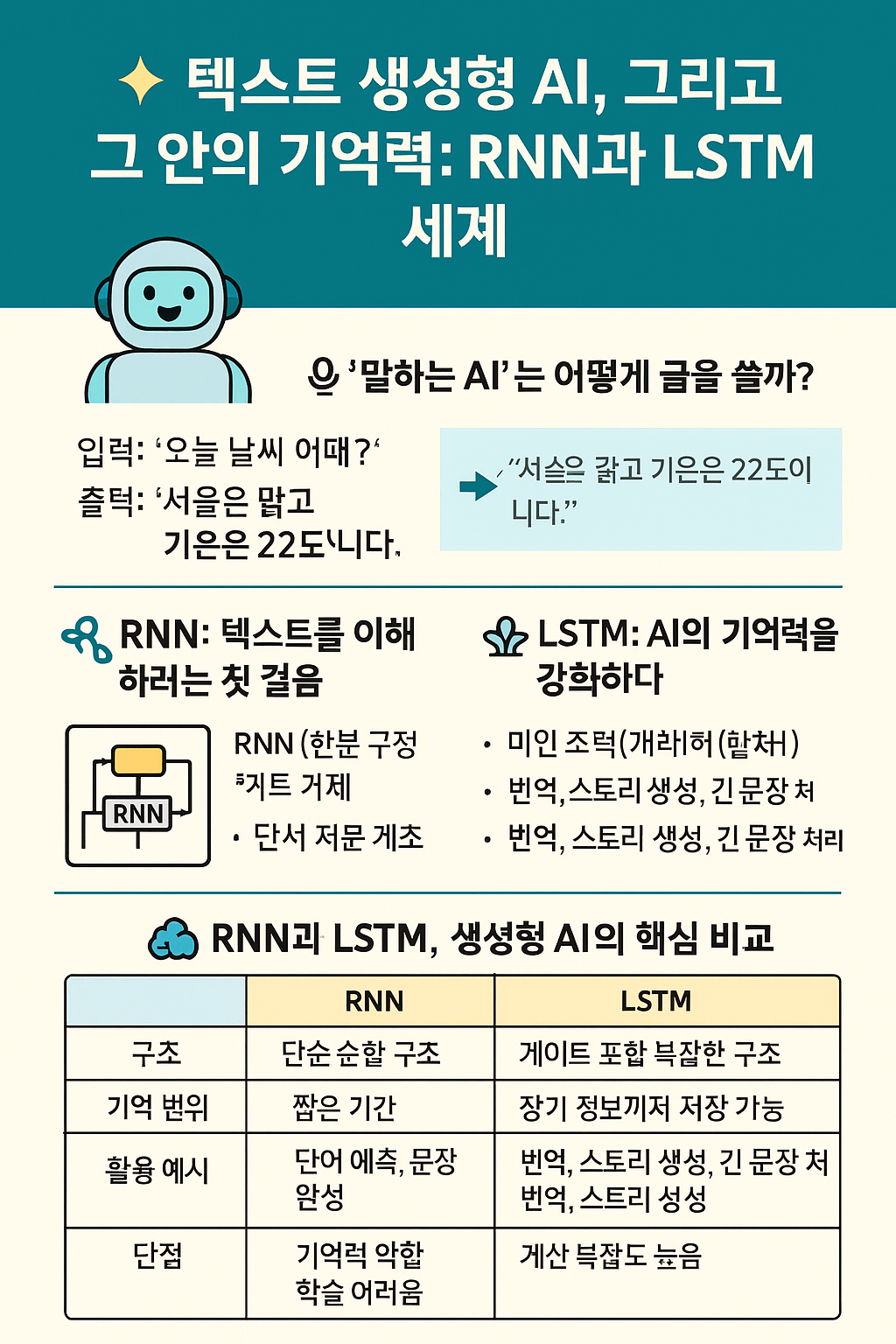

🤖 “말하는 AI”는 어떻게 글을 쓸까?

요즘 우리 주변에는 “말하는 인공지능”이 넘쳐납니다. ChatGPT, Bing Copilot, 네이버 하이퍼클로바 등은 사람처럼 자연스럽게 글을 만들어내는 생성형 인공지능입니다.

이런 AI는 단순한 암기나 검색이 아닌, 문맥을 기억하고 새로운 문장을 예측하는 능력을 가집니다. 그 핵심에는 RNN과 LSTM이라는 인공지능 구조가 숨어 있습니다.

📌 텍스트 생성형 AI란?

텍스트 생성형 AI는 기존에 학습한 데이터를 기반으로, 문맥에 맞는 새 문장, 문단, 대화를 생성하는 인공지능입니다.

- 입력: “오늘 날씨 어때?”

- 출력: “서울은 맑고 기온은 22도입니다.”

이처럼 AI는 다음 단어가 무엇이 올지 예측하며 텍스트를 생성합니다.

🔁 RNN: 텍스트를 이해하려는 첫 걸음

RNN(Recurrent Neural Network)은 문장처럼 시간 순서가 있는 데이터(시퀀스)를 처리하기 위해 만들어진 구조입니다.

이전 단어의 의미를 기억하면서, 다음 단어를 예측하는 방식으로 동작합니다.

📚 RNN 활용 예시

- 문장 자동완성

- 음성 인식

- 날씨 예측

- 단어 예측

⚠️ RNN의 한계

문장이 길어지면 앞 내용을 잘 기억하지 못합니다. 이를 기울기 소실(vanishing gradient) 문제라고 부릅니다.

🧠 LSTM: AI의 기억력을 강화하다

LSTM(Long Short-Term Memory)는 RNN보다 더 깊은 기억력을 가진 구조입니다.

내부에 게이트(gate)라는 장치를 두어, 어떤 정보는 저장하고, 어떤 정보는 잊을지를 스스로 판단합니다.

📚 LSTM 활용 예시

- 기계 번역 (예: 영어 → 한국어)

- 대화의 흐름 기억 (챗봇)

- 감정 분석, 소설/뉴스 생성

⚠️ LSTM의 단점

구조가 복잡하고 계산량이 많아 학습 시간이 오래 걸립니다.

🧾 RNN vs LSTM 비교

| 항목 | RNN | LSTM |

|---|---|---|

| 구조 | 단순 순환 구조 | 게이트 포함 복잡한 구조 |

| 기억 범위 | 짧은 기간 유지 | 장기 기억 가능 |

| 활용 분야 | 단어 예측, 시퀀스 처리 | 번역, 대화, 감정 분석 |

| 주요 문제 | 기울기 소실 | 계산 복잡도 |

✍️ 텍스트 생성 AI는 이렇게 작동해요

- 수많은 문서/대화 데이터를 학습

- 입력된 문장을 보고 문맥 파악

- RNN, LSTM(또는 Transformer) 구조를 통해 다음 단어 예측

- 사람처럼 자연스럽게 이어지는 문장 출력

🌟 왜 중요한가요?

- 마케팅 문구, 블로그 글, SNS 콘텐츠 자동 생성

- 고객 응대 자동화

- 1인 크리에이터 시대에 강력한 도구로 활용 가능

🧠 한 줄 요약

텍스트 생성형 AI는 사람처럼 말을 이어가기 위해, RNN과 LSTM이라는 뇌를 빌려 문맥을 기억하며 문장을 만들어냅니다.

📌 해시태그

#생성형AI #텍스트생성 #RNN #LSTM #자연어처리 #AI작동원리 #ChatGPT #딥러닝기초 #인공지능

반응형

'경제경영비즈니스' 카테고리의 다른 글

| LLM과 자연어처리: AI가 사람처럼 말할 수 있는 이유 (1) | 2025.05.24 |

|---|---|

| 제이슨 자다(Jason Zada): 데이터 시대의 창작자, AI 시대의 경고자 (0) | 2025.05.24 |

| RNN과 LSTM: 인공지능의 기억력 (1) | 2025.05.24 |

| 에어비앤비와 외부 플랫폼 달력 동기화로 오버부킹 방지하는 방법 (0) | 2025.05.24 |

| 기존 인공지능 vs 생성형 인공지능: 무엇이 다를까? (2) | 2025.05.23 |